För några dagar sedan introducerade OpenAI personligt anpassade versioner av chatGPT, en slags enklare AI-agenter, som vem som helst kan skapa. Jag kunde inte låta bli att börja utforska dessa, inte minst utifrån min egen historia i detta fält. Så innan jag berättar lite om mina tankar om AI-agenter och GPTs, som OpenAI kallar sina, så tänkte jag ta några kliv tillbaka i historien.

Jag höll min första föreläsning på en AI-konferens i oktober 2010 i Glasgow. I föreläsningen beskrev jag en hypotetisk framtid där man i AI-baserade system skulle kunna interagera med olika typer av digitala karaktärer, eller agenter, som det kallas. Jag utgick ifrån teorier dels om interaktivt berättande, men också från hur man designar levande rollspel för att beskriva utvecklingen av ett tekniskt system som skulle kunna hantera multipla AI-agenter, med olika personlighet, som också interagerar med människor som använder systemet. I föreläsningen beskrev jag hur just kunskap om hur man designar levande rollspel kan bli värdefull när det handlar om att utveckla AI-agenter som ska upplevas som trovärdiga.

Det var längesedan sist jag tänkt på denna föreläsning. Men i våras 2023 kom jag att tänka på den igen. Föreläsningen kom att bli utgångspunkten för mitt eget lärande inom artificiell intelligens och framförallt området interaktiva agenter, och dess potentiella design i olika sammanhang. Vid denna tid var de interaktiva agenter som skapades mycket primitiva och ofta designade ovanpå olika former av expertsystem eller trådade narrativa strukturer som skapade en mycket begränsad interaktion. De kändes inte levande. Min hypotes var att metoder för design av levande rollspel skulle kunna göra dessa system mera levande och trovärdiga, och göra interaktionen med en digital agent mycket bättre för användaren.

Föreläsningen i Glasgow väckte intresse, och jag fick tillfälle att prata om den med flera konferensdeltagare efteråt och under middagen på kvällen. Några av de jag träffade där visade sig komma från Disney Imagineering, som är Disneys utvecklingsmiljö, där de uppfinner nya saker för både temaparkerna och för filmer. Våra samtal kom att handla om hur de tankar jag hade pratat om på föreläsningen skulle kunna användas i utvecklingen av framtida attraktioner på Disney World.

De så kallade Disney Imagineers jag träffade på konferensen i Glasgow, valde en tid senare att höra av sig och utveckla kontakten vidare. Jag besökte dem i Hollywood för att presentera ytterligare tankar och idéer, och gänget från Disney kom att besöka Göteborg, för att ta del av ett antal olika levande rollspel som jag och andra arrangerade under ett antal intensiva dagar. Jag åkte tillbaka till Disney för att bidra med kunskap och perspektiv igen vid ett par tillfällen.

Under mina besök hos Disney och även efteråt kom mina tankar om AI-agenter att utvecklas en hel del. De experiment som Disney genomförde, några som kommit att bli verklighet i ett antal av deras attraktioner och system, fick mig att förstå att AI-agenter behöver vara otroligt bra för att en människa som använder ett IT-system som nyttjar dessa, får en god upplevelse. Vid den tid jag höll på med dessa experiment var det oerhört tidsödande, dyrt och dessutom inte särskilt bra alls.

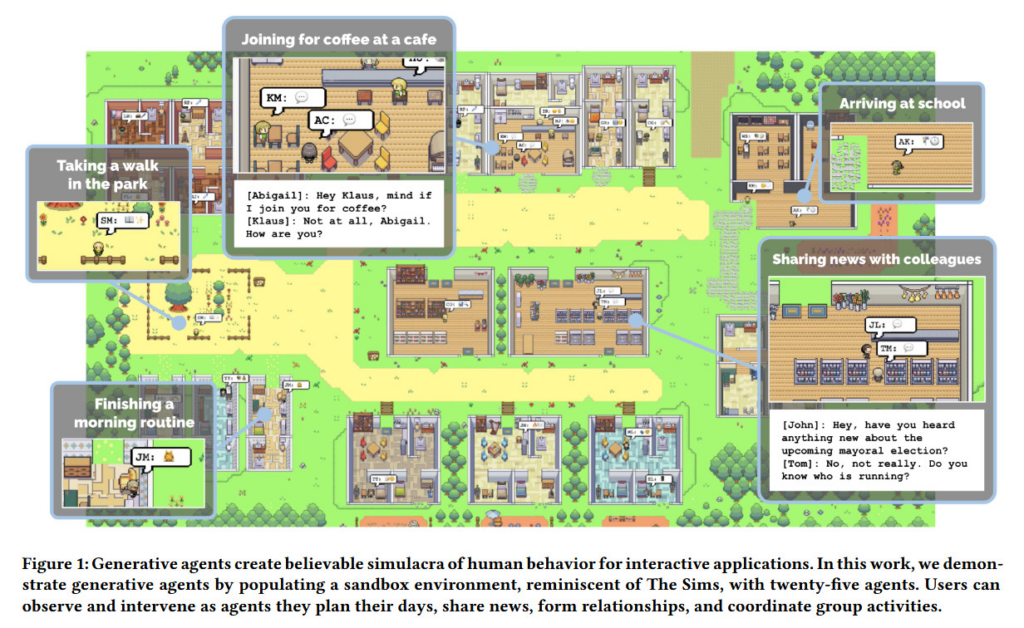

Så i våras, 2023, kom jag att förändra min bild av AI-agenter och dess möjligheter idag helt och hållet. Jag läste en fascinerande vetenskaplig studie som fångade min uppmärksamhet. Den handlade om skapandet av så kallade generativa agenter, en ny form av datorprogram designade för att imitera mänskligt beteende på ett övertygande sätt. Dessa agenter hade förmågan att utföra vardagliga handlingar såsom att vakna upp, laga frukost, och gå till jobbet. Inte nog med det, de kunde även agera som konstnärer eller författare, ha egna åsikter i olika frågor, observera varandra, initiera samtal, minnas tidigare händelser och planera för framtiden.

Forskarna bakom studien hade integrerat en avancerat stor språkmodell i dessa agenter, vilket tillät dem att lagra och reflektera över sina erfarenheter. Det mest spännande var hur dessa agenter testades i en virtuell miljö som påminde om spelet ”The Sims”. I denna miljö levde 25 agenter i en liten stad där de kunde interagera både med varandra och med användare via naturligt språk. Ett fascinerande exempel från studien var hur agenterna autonomt kunde organisera en fest på Alla hjärtans dag. De spred inbjudningar, skapade nya bekantskaper, frågade varandra på dejter och koordinerade för att dyka upp på festen tillsammans. Denna typ av interaktion visade på en imponerande nivå av trovärdigt individuellt och socialt beteende. Studien visade på den stora potentialen i att kombinera stora språkmodeller med interaktiva agenter.

För min del väckte denna artikel många tankar om hur jag tänkt för mer än tio år sedan, men inte sett som praktiskt genomförbart. Genom att skapa dessa generativa agenter, visade studien hur man kan skapa möjligheter att simulera mänskligt beteende på ett sätt som tidigare inte varit möjligt.

Denna artikel från i våras var ett enskilt och avgränsat exempel på användning av agenter i kombination med stora språkmodeller. Vid samma tid började det experimenteras, inte minst bland de som arbetar med öppen mjukvarubaserade stora språkmodeller, för hur agenter skulle kunna bli mera allmänt användbara. Också OpenAI, Microsoft och Google beskrev i våras olika scenarion där detta skulle kunna vara möjligt. Utvecklingen gick fortare.

Så häromdagen lanserade så OpenAI en ny uppsättning verktyg, som gör det möjligt för vem som helst som är betalande kund till deras chatGPT-tjänst att skapa egna agenter, antingen genom deras gränssnitt eller genom att använda deras APIer.

OpenAI har alltså introducerat anpassningsbara versioner av ChatGPT, som de kallar GPTs. Dessa tillåter användare att skapa egna versioner av ChatGPT för specifika ändamål, som att lära ut brädspelsregler, underlätta barns matematikinlärning, eller designa klistermärken. Dessa GPTs kräver ingen programmeringskunskap för att skapas, vilket gör dem tillgängliga för många, inte bara att använda, utan också att skapa. På ganska kort tid har jag själv experimenterat och tagit fram två GPTs, en som bygger på Språkrådets skriftregler för myndigheter och som hjälper användaren att skriva klarspråk. Den heter Klarspråk och kan ge feedback på text och hjälpa en att skriva. En annan GPT jag skapat heter Signal Digital och tar sin utgångspunkt i ett antal texter och dokument från myndigheter och forskning och som hjälper till att coacha inom samhällets digitalisering, digital transformation, förnyelse och innovationsledning.

Användare kan konfigurera sina GPTs för personligt bruk, företagsintern användning eller för att dela med andra. Processen innebär att starta en konversation med AI, ge den specifika instruktioner och välja dess funktioner, som webbsökning, bildskapande eller dataanalys. För tillfället är vissa GPTs tillgängliga för ChatGPT Plus- och Enterprise-användare men OpenAI planerar att göra dessa GPTs tillgängliga för fler användare framöver.

Den här utvecklingen av AI-baserade agenter är verkligen tankeväckande. Den öppnar upp för ett helt nytt sätt att interagera med datorer, där du som användare istället för att använda specifika datorprogram för att göra olika saker, istället tar hjälp av en agent, som i sin tur drar nytta av såväl program som kunskap på internet för att uppnå det man efterfrågar av den. Olika agenter kan tänkas vara bra på olika saker. Någon agent kanske blir den som vet mycket om just dig, och hjälper dig med saker som andra inte kan.

Även om det går att se många spännande och intressanta möjligheter med teknologin, så väcker den också frågor, flera som brådskar för oss att ta om hand, eftersom utvecklingen går så pass fort som den gör. I en värld där generativa agenter och avancerade språkmodeller som GPT blir alltmer integrerade i vårt samhälle, också inom offentlig sektor och i myndighetsutövning, står vi inför en rad etiska utmaningar. Ett centralt problem är risken för diskriminerande mönster och andra typer av bias i dessa system. Dessa bias kan uppstå ur de data som använts för att träna modellerna, och kan därför komma att påverka hur dessa agenter agerar och interagerar med människor. Ett exempel kan vara en AI-agent som används för att automatisera vissa aspekter av myndighetsbeslut. Om den stora språkmodell som ligger till grund för AI-agenten har bias i dess träningsdata, kan det resultera i att agenten har inlärda fördomar, som i sin tur kan dessa påverka de beslut den bidrar till att fatta på ett orättvist sätt. Detta gör det kritiskt viktigt att utveckla väl anpassade testningsmetoder för att identifiera och korrigera dessa bias.

En sådan testning bör inte bara omfatta tekniska aspekter som att säkerställa att språkmodeller inte producerar diskriminerande eller fördomsfulla svar, utan även inkludera bredare samhällsvetenskapliga perspektiv. Det innebär att förstå och analysera hur dessa agenter påverkar olika grupper inom samhället, och säkerställa att de inte förstärker befintliga sociala orättvisor.

En konsekvens av detta är att samverkan mellan aktörer, och etableringen av testmiljöer och aktörer blir av stor vikt. I dessa miljöer behöver ingenjörer, etiker, sociologer, jurister och andra experter tillsammans med användare och andra viktiga aktörer bidra till att utforma och delta i testningsprocesser. Dessa miljöer behöver kontinuerligt utvecklas och anpassas, eftersom både samhället och teknologin ständigt är i förändring. Att hantera dessa utmaningar på ett effektivt och ansvarsfullt sätt blir avgörande för att säkerställa att användningen av generativa agenter och stora språkmodeller bidrar positivt till samhället, snarare än att förstärka befintliga problem.

När jag tänker på tiden från mitt första föredrag, där jag resonerade kring en hypotes om att använda agenter för dialog, till den utveckling vi sett bara det senaste året, så är det hissnande. Vi står inför en genuint omvälvande digital transformation, där generativa agenter kommer att spela en viktig roll. Här blir samhällets, och inte minst politikens kunskap om denna utveckling alldeles avgörande, för att skapa så goda förutsättningar som möjligt.

Lämna ett svar